#

TabbyAPI

Uma aplicação baseada em FastAPI que permite gerar texto usando um LLM com o backend Exllamav2, com suporte para modelos Exl2, GPTQ e FP16.

#

Início Rápido

- Siga as instruções de instalação no GitHub oficial do TabbyAPI.

- Crie seu config.yml para definir o caminho do seu modelo, modelo padrão, comprimento de sequência, etc. Você pode ignorar a maioria (se não todas) dessas configurações se desejar.

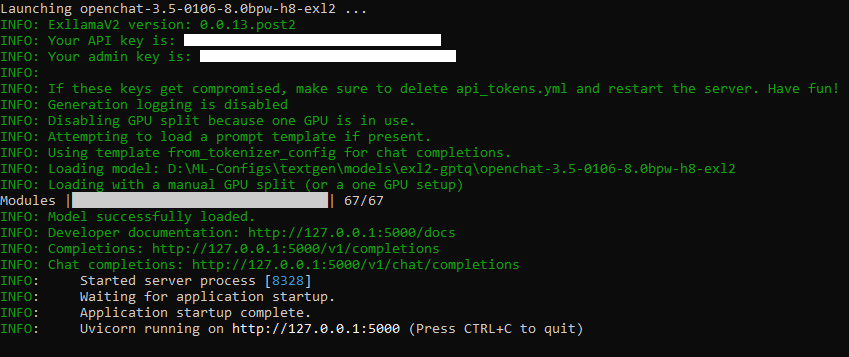

Inicie o TabbyAPI. Se funcionou, você deverá ver algo assim:

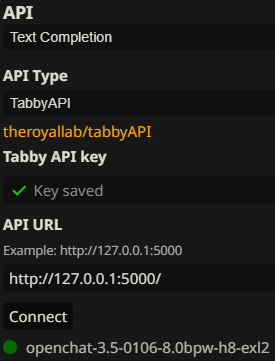

- Em Text Completion API no SillyTavern, selecione TabbyAPI.

- Copie sua chave de API do terminal do TabbyAPI para

Tabby API keye certifique-se de que seuAPI URLestá correto (deve serhttp://127.0.0.1:5000por padrão).

Se você fez tudo corretamente, deverá ver algo assim no SillyTavern:

Agora você pode conversar usando TabbyAPI!

#

TabbyAPI Loader

Os desenvolvedores do TabbyAPI criaram uma extensão oficial para carregar/descarregar modelos diretamente do SillyTavern. A instalação é simples:

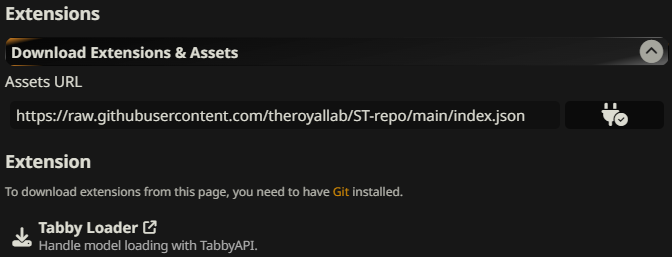

- No SillyTavern, clique na aba Extensions e navegue até Download Extensions & Assets.

- Copie

https://raw.githubusercontent.com/theroyallab/ST-repo/main/index.jsonem Assets URL e clique no botão de plug à direita. Você deverá ver algo assim. Clique no botão de download ao lado de Tabby Loader.

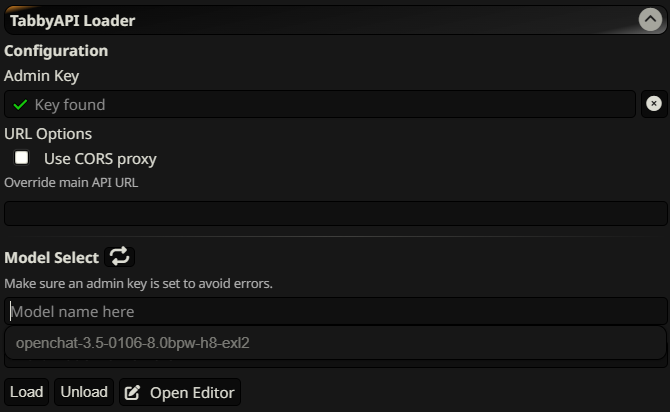

- Se a instalação foi bem-sucedida, você deverá ver uma mensagem pop-up verde no topo da sua tela. Na aba extensions, navegue até TabbyAPI Loader e copie sua chave de administrador do terminal do TabbyAPI para Admin Key.

- Clique no botão de atualização ao lado de Model Select. Quando você clicar na caixa de texto logo abaixo, deverá ver todos os modelos no seu diretório de modelos.

Agora você pode carregar e descarregar seus modelos diretamente do SillyTavern!

#

Suporte

Ainda precisa de ajuda? Visite o GitHub do TabbyAPI para um link ao servidor Discord oficial do desenvolvedor e leia a wiki.